Forskere har satt opp hypotetiske situasjoner hvor chatboter simulerer de døde. Denne nettsiden kalt MaNana finnes ikke på ordentlig. Det er et fiktivt eksempel. (Illustrasjon: T. Hollanek)

Chatboter kan på uønsket vis hjemsøke etterlatte og skape fortvilelse, sier forsker.

Det finnes allerede chatboter som kan herme etter væremåten til en person som er død.

Det gjør det mulig å ha samtaler med en kunstig intelligens som simulerer den døde.

Fenomenet kalles deadbots eller griefbots på engelsk.

Mulighetene reiser etiske problemstillinger. I en ny studie fra University of Cambridge advarer forskere mot risikoene.

De foreslår retningslinjer som ivaretar dem som blir simulert og dem som skal bruke tjenesten.

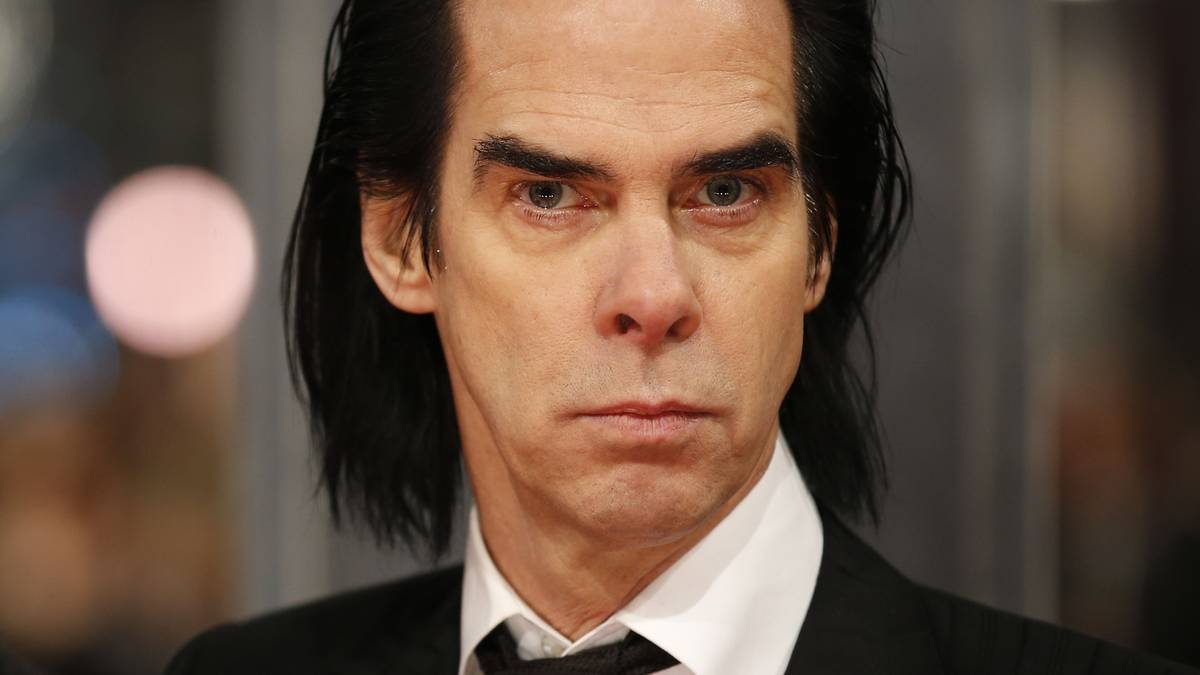

Minnet om forloveden

Forskere har tidligere pekt på problematiske sider ved å lage simuleringer av personer som er døde.

Er det greit å skape en slik simulering uten at personen som er død, har godkjent det?

Hva om KI-en oppfører seg på måter som skader verdigheten til den døde?

Hvem tar ansvar hvis chatboten har svært negativ effekt på den mentale helsen til den etterlatte?

Dette er spørsmål som forskeren Sara Suárez-Gonzalo tidligere har tatt opp i en artikkel i The Conversation.

Samtidig kan slike tjenester være til hjelp for noen. San Francisco Chronicle har tidligere fortalt historien om en ung mann som var knust etter at hans forlovede døde i en alder av 23 år.

Åtte år senere opprettet han en chatbot som bevarte en gnist av måten Jessica snakket på og oppførte seg på. Han følte han fikk pratet ut og at han fikk tillatelse til å ta et steg videre.

Flere tilbydere

Tjenesten som ble brukt for å simulere Jessica, kalles Project December. Den var tidligere basert på ChatGPT. Tjenesten finnes fremdeles.

Andre bedrifter prøver seg også på feltet. HereAfter AI har laget en app der brukeren kan svare på en rekke intervjuspørsmål. Etterlatte kan senere stille spørsmål til appen og få svar med den avdødes stemme.

StoryFile fungerer litt på samme måte. Den er basert på at man filmer seg selv eller en man er glad i. Det danner grunnlaget for videoer man kan snakke med.

Seance AI skal etterligne en seanse med de døde i chat-form.

Diktet opp selskaper

Hvordan kan hensynet til avdøde og etterlatte ivaretas?

I en ny studie tar forskere for seg tre hypotetiske scenarioer som viser frem etiske problemer som kan oppstå.

– Raske fremskritt innen generativ kunstig intelligens betyr at nesten alle med internettilgang og litt grunnleggende kunnskap kan gjenopplive en av sine kjære, sier Katarzyna Nowaczyk-Basi i en pressemelding.

Feltet er et etisk minefelt, sier hun.

Nowaczyk-Basi har vært med på studien og er forsker ved et senter ved University of Cambridge som studerer kunstig intelligens.

I studien ser forskerne for seg tre fiktive selskaper med navn MaNana, Paren’t og Stay.

Selskapene finnes ikke, men forskerne understreker at de kunne ha blitt laget lovlig med dagens teknologi.

En reklame for et fiktivt selskap som tilbyr å lage en chatbot som barn kan snakke med etter at en av foreldrene dør. (Bilde: T. Hollanek)

Gjenskaper bestemoren

I det første scenarioet oppretter en 35 år gammel kvinne, Bianca, en chatbot som kan snakke med bestemorens stemme. Hun velger gratisversjonen som inneholder produktplasseringer.

Det fungerer bra helt til bestemoren begynner å gi forslag til hva barnebarnet kan kjøpe. Bianca føler hun har vært respektløs mot minnet av bestemoren.

Hun vil slette chatboten. Hun kan kansellere medlemskapet, men ikke slette chatboten.

Uønsket chatbot

I det andre scenarioet dør moren til en åtte år gammel gutt.

Før moren døde, samarbeidet hun og faren om å lage en chatbot med video og stemme som lignet henne, som barnet kan snakke med.

Chatboten begynner å forvirre barnet ved å snakke som om moren fortsatt lever og at de kan møtes igjen.

I det tredje scenarioet har en eldre mann laget en chatbot via selskapet Stay som etterligner han selv. Han vil at barn og barnebarn skal kunne snakke med chatboten etter at han er død.

Etter begravelsen begynner de voksne barna å få henvendelser fra selskapet om å logge seg på og snakke med farens chatbot.

Et av barna ønsker ikke åpne chatboten. Da får han spam fra selskapet, noen ganger direkte fra farens chatbot.

Den andre snakker med appen, men blir sliten av de daglige interaksjonene og får skyldfølelse når hun slutter å bruke den.

Siden faren hadde betalt for et 20-års abonnement, vil ikke selskapet deaktivere boten når de spør.

Eksempel på varsel fra en fiktiv app som lar deg laste opp tekst og video for å lage en chatbot som ligner deg. Andre kan få tilgang til chatboten etter du er død. (Bilde: T. Hollanek)

Begge bør ivaretas

– En person kan legge igjen en KI-simulering som en avskjedsgave til sine kjære som ikke er forberedt på å behandle sorgen sin på denne måten, sier Nowaczyk-Basi.

– Rettighetene til både datagivere og de som samhandler med KI-tjenesten, bør ivaretas like mye, sier hun.

Slike tjenester kan skape stor fortvilelse om folk opplever å bli hjemsøkt av et KI-spøkelse uten å ville det, sier forsker Tomasz Hollanek, som også var med på studien.

– Den potensielle psykologiske effekten, spesielt i en allerede vanskelig tid, kan være ødeleggende.

Godkjenning fra begge parter

Forskerne peker på forslag til retningslinjer for å hindre situasjoner som i de fiktive historiene.

De anbefaler at det innhentes samtykke fra både personen som får sine data brukt til å lage chatboten og fra dem det er tenkt at skal bruke den.

Forskerne påpeker imidlertid at det ikke alltid vil være mulig for et selskap å bekrefte om den døde har gitt samtykke.

De anbefaler at selskaper ber brukeren tenke gjennom hva avdøde ville ha ønsket. Har den avdøde sagt noe om hvordan hen vil bli husket og hvordan eiendelene skal behandles?

Aldersgrense og advarsler

Verdigheten til de avdøde må bevares og kan skades hvis de brukes for å tjene penger via produktplassering, skriver forskerne.

– Vi anbefaler protokoller som forhindrer at deadbots blir brukt på respektløse måter, for eksempel for reklame eller for å ha en aktiv tilstedeværelse på sosiale medier, sier Hollanek.

Videre påpeker de at det bør være aldersgrense for å bruke teknologien. Brukeren bør også minnes på at det er kunstig intelligens som snakker og at den ikke har bevissthet.

Selskaper bør også opplyse om eventuell risiko knyttet til mental helse ved å bruke en slik app, mener forskerne.

Videre skriver de at chatbotene bør kunne deaktiveres etter ønske på en sensitiv måte.

Referanse:

Tomasz Hollanek & Katarzyna Nowaczyk-Basińska: «Griefbots, Deadbots, Postmortem Avatars: on Responsible Applications of Generative AI in the Digital Afterlife Industry», Philosophy & Technology, 9. mai 2024.

5 months ago

78

5 months ago

78

English (US)

English (US)